SEO対策

28年08月11日07:14

SEOについては、まったく気にならないと言えば嘘になる。

どんなページでもいつかはインデックスされるかもしれないが、やはり早く検索してもらいたいという心理はみんな同じでしょう。

最低限、やらなければならないのが、sitemap.xmlファイルの作成でしょう。

RapidWeaverでのやり方としては「SiteMap」というプラグインが便利です。いちいちsitemap.xmlファイルを自分で作成したり、他のサイトに頼んだりせずとも自動的にやってくれるのは本当に重宝する。

ここで自動で作成されたsitemap.xmlの他に sitemap_index.xml や sitemap_mac.xml などのファイルも一緒にアップされている。前のバージョンでは無かったファイルだが、どのような役目なのか。

ひとつの sitemap.xml には url は最大50000件、ファイルサイズは10MBまでという制限があるとか。ファイルサイズが10MBを超えた場合は gzip 形式で圧縮して10MBに収めればそれでもOKらしい。

上記制限をどうしても超えてしまう場合は複数の sitemap.xmlに分割することが可能。その時に使うのが、sitemap_index.xml 。別途作成してそこに複数のsitemap.xmlファイルを登録(もちろん.xmlのファイル名を変えて)。下記のようになる。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

http://polo2009.com/sitemap_mac.xml

2011-08-27

圧縮したファイルの場合ーーーーーーーーーーーーーーーーーーーーーーーー

http://www.example.com/sitemap1.xml.gz

2004-10-01T18:23:17+00:00

http://www.example.com/sitemap2.xml.gz

2005-01-01

sitemap.xmlやsitemap_index.xmlは通常サイトのトップページに配置します。

ここにおいておけば、sitemap.xml に対応したロボットが自動的にファイルを読み込んでくれます。

これうそです。各検索エンジンごとにファイルの場所を知らせてあげる必要があるとか。

グーグルからはYahooに比べて沢山の人がアクセスしてくれる。しかしYahooからは少ない(あるにはある)。その謎を知りたい。

このSitemap.xmlはGoogle Analyticsとは関係ない。Google Analyticsと関係があるのはトラッキングコード。Sitemap.xmlは単に検索ロボットの為のもの。

ならばSitemap.xmlがあればYahooからも素人考えでは同じようにアクセスがあってもいいように思うのだが……

そこで色々サイトで調べてみると「robots.txt」というファイルの存在がある。

アクセスログを見る環境を持っている人には分かるとか、ロボットは、最初にサイトトップのrobots.txtにアクセスするらしい。

検索エンジン用サイトマップとしては以下のように記述するらしい。

ーーーーーーーーーーーーーーーーーーー

User-agent: *

Sitemap: http://ドメイン/sitemap.xml

Disallow:

ーーーーーーーーーーーーーーーーーーー

単に

Sitemap: http://ドメイン/sitemap.xml

ではダメなのかな?

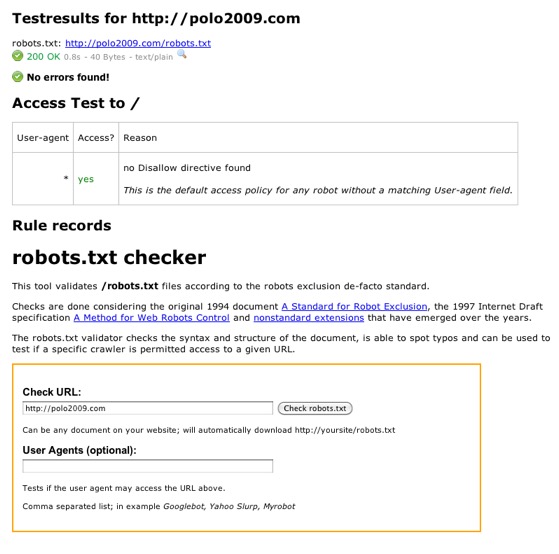

この「robots.txt」ファイルが有効化どうか、確認できるサイトがあります。

http://www.frobee.com/robots-txt-check

この、robots.txt検証ツールは、ドキュメントの構文と構造をチェックして、誤植を見つけることができて、テストするのに使用できます。

No errors found!( エラーは見つかりませんでした!)と出ている。

no Disallow directive found

This is the default access policy for any robot without a matching User-agent field.

何かを禁止する指令が見つかりませんでした(つまりすべてロボットに見てもらうということ)

これは、一致するUser - Agentフィールドを得ることなくロボットのデフォルトのアクセスポリシーです。

※この文章はアクセス拒否の記述を何も書いていないのでUser - Agentフィールドの拒否記述を見つけることが出来なかったということを書いてあるようだ。

どんなページでもいつかはインデックスされるかもしれないが、やはり早く検索してもらいたいという心理はみんな同じでしょう。

最低限、やらなければならないのが、sitemap.xmlファイルの作成でしょう。

RapidWeaverでのやり方としては「SiteMap」というプラグインが便利です。いちいちsitemap.xmlファイルを自分で作成したり、他のサイトに頼んだりせずとも自動的にやってくれるのは本当に重宝する。

ここで自動で作成されたsitemap.xmlの他に sitemap_index.xml や sitemap_mac.xml などのファイルも一緒にアップされている。前のバージョンでは無かったファイルだが、どのような役目なのか。

ひとつの sitemap.xml には url は最大50000件、ファイルサイズは10MBまでという制限があるとか。ファイルサイズが10MBを超えた場合は gzip 形式で圧縮して10MBに収めればそれでもOKらしい。

上記制限をどうしても超えてしまう場合は複数の sitemap.xmlに分割することが可能。その時に使うのが、sitemap_index.xml 。別途作成してそこに複数のsitemap.xmlファイルを登録(もちろん.xmlのファイル名を変えて)。下記のようになる。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

圧縮したファイルの場合ーーーーーーーーーーーーーーーーーーーーーーーー

sitemap.xmlやsitemap_index.xmlは通常サイトのトップページに配置します。

ここにおいておけば、sitemap.xml に対応したロボットが自動的にファイルを読み込んでくれます。

これうそです。各検索エンジンごとにファイルの場所を知らせてあげる必要があるとか。

グーグルからはYahooに比べて沢山の人がアクセスしてくれる。しかしYahooからは少ない(あるにはある)。その謎を知りたい。

このSitemap.xmlはGoogle Analyticsとは関係ない。Google Analyticsと関係があるのはトラッキングコード。Sitemap.xmlは単に検索ロボットの為のもの。

ならばSitemap.xmlがあればYahooからも素人考えでは同じようにアクセスがあってもいいように思うのだが……

そこで色々サイトで調べてみると「robots.txt」というファイルの存在がある。

アクセスログを見る環境を持っている人には分かるとか、ロボットは、最初にサイトトップのrobots.txtにアクセスするらしい。

検索エンジン用サイトマップとしては以下のように記述するらしい。

ーーーーーーーーーーーーーーーーーーー

User-agent: *

Sitemap: http://ドメイン/sitemap.xml

Disallow:

ーーーーーーーーーーーーーーーーーーー

単に

Sitemap: http://ドメイン/sitemap.xml

ではダメなのかな?

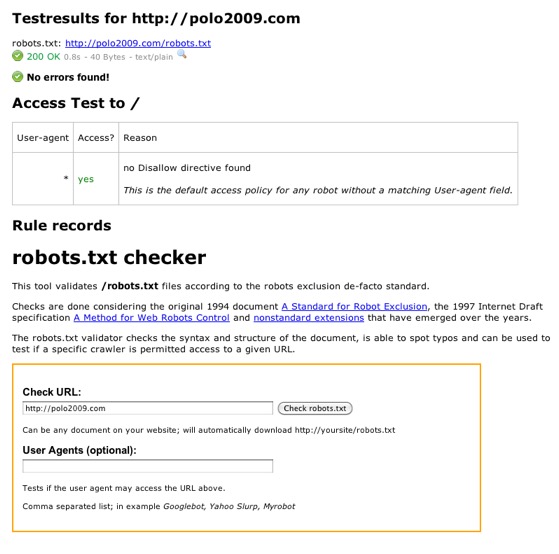

この「robots.txt」ファイルが有効化どうか、確認できるサイトがあります。

http://www.frobee.com/robots-txt-check

この、robots.txt検証ツールは、ドキュメントの構文と構造をチェックして、誤植を見つけることができて、テストするのに使用できます。

No errors found!( エラーは見つかりませんでした!)と出ている。

no Disallow directive found

This is the default access policy for any robot without a matching User-agent field.

何かを禁止する指令が見つかりませんでした(つまりすべてロボットに見てもらうということ)

これは、一致するUser - Agentフィールドを得ることなくロボットのデフォルトのアクセスポリシーです。

※この文章はアクセス拒否の記述を何も書いていないのでUser - Agentフィールドの拒否記述を見つけることが出来なかったということを書いてあるようだ。

blog comments powered by Disqus